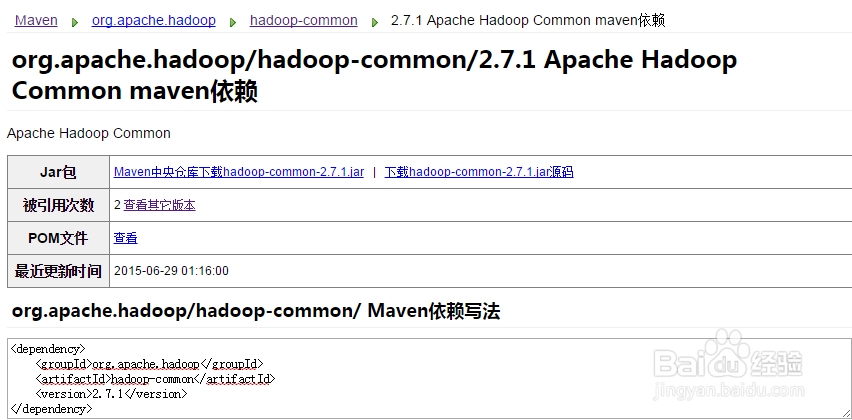

1、引入hadoop-common的jar包

2、注意对照后续需要导入的包

这里需要注意下,用的都是mapreduce包下面的内容。

旧的API中提供包在mapred中,网上有很多文章都用的是这个的,注意区别。

3、创建对应的Table实体类

实现Writable, DBWritable接口

加点输出,到时候执行时看效果。

4、编写Mapper,注意VALUEOUT

之前看到很多用tostring拼成Text,然后再reduce中进行字符串分割的,有很大的限制,实际中肯定会有很大问题。应该也可以直接用Table对象吧,这个还没好好研究下。

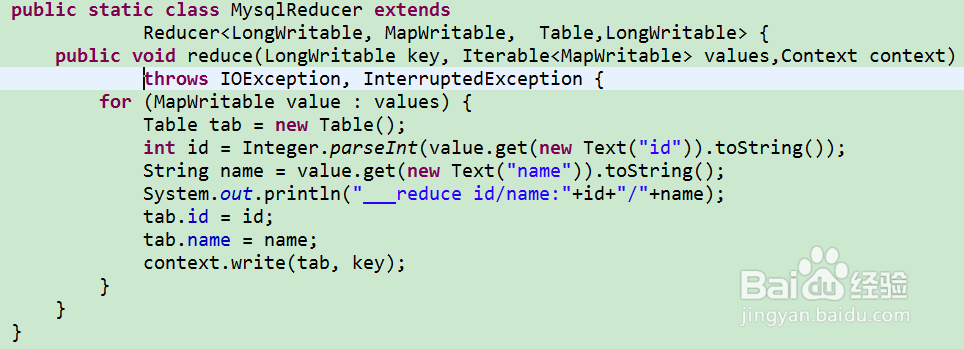

5、编写Reducer

将接受到的信息写入DB

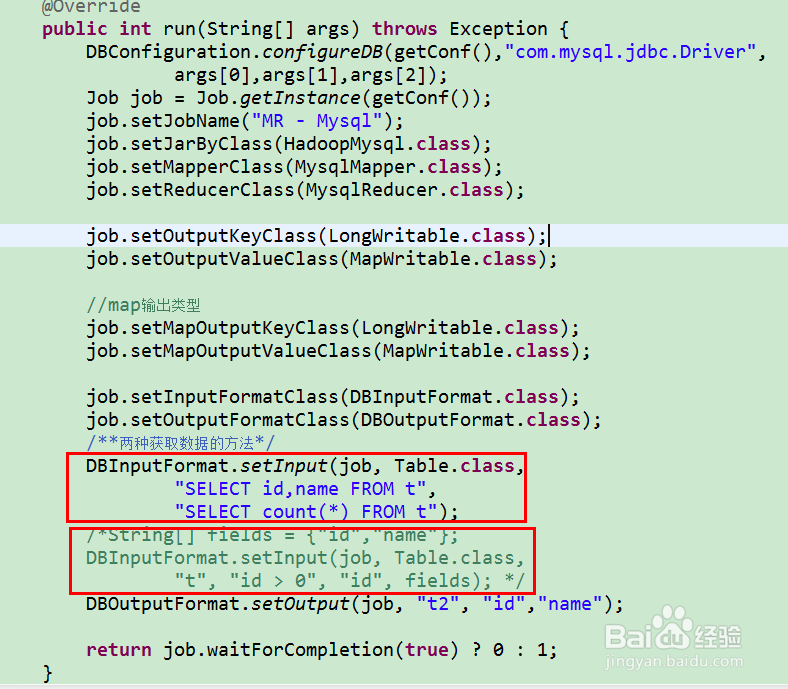

6、编写执行方法

关键是用DBInputFormat、DBOutputFormat

Input方法提供了两种实现。

7、最后运行下查看执行效果

数据成功复制!